目次

トロッコ問題とは

トロッコ問題は、状況判断に関する問題です。倫理的な思想・立場によって回答が変わる倫理問題で、人間の場合は自らの思想信条に沿って動き、自らが責任を負います。

有名なトロッコ問題の一例です。

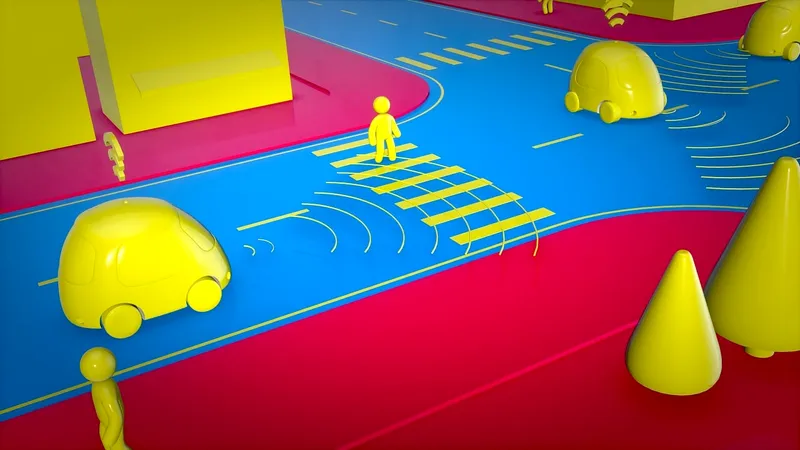

どうしても避けられない状況下で、左の(A)のケースでは、脇の道を歩く 1 人の通行人か、目の前の複数の歩行者たちのどちらか、真ん中の(B)のケースでは、目の前の 1 人の歩行者か自動運転車に乗っている人間のどちらか、右の(C)のケースでは、目の前の複数の歩行者たちか自動運転車に乗っている人間のどちらか、を自動運転車が殺してしまうことになります。

それぞれのケースにつき、どちらがより倫理的な選択か、約 2000 人に調査しました。 その結果、大多数の人が「大勢の人の命が救われるなら、1 人か 2 人の命が失われても仕方ない」という考え方を持ったそうです。

右の(C)のケースのように「10 人の歩行者の命を救うためなら自動運転車に乗っている 1 人の命を犠牲にする」ように 自動運転車がプログラムされても問題がない、と答えたのは参加者の 75%にまでのぼりました。

自動運転車に関する倫理ルール

2017 年 6 月に、ドイツ政府が招集した専門家による委員会が「自動運転車に関する倫理ルール 20 項目」を発表しました。そのルールの中には、「避けられない事故が起きた場合、人間の年齢、性別、心身の状態などをカテゴライズして考慮することを厳しく禁じる。一般レベルでのルールとして犠牲者の数を減らすよう挙動する、というものは受け入れられる」という少し踏み込んだルールが見られます。

一方、2017 年 7 月に、総務省は、AI 開発者が留意すべき原則「AI 開発ガイドライン案」を公表しました。倫理規定が必要との声が世界で強まる中、国際会議の場で「日本発の叩き台」として提案する狙いです。

AI には「人間の考える」倫理ルールが必要

もし、あなたの自動運転車が、AI の判断で右の(C)の動きをする車だと知ったら、その車に乗りますか?

「AI 自身がルールを作る」世界がやって来る前に、「人間の考える」倫理ルールを早急に作っておく必要があると感じています。

AI の倫理問題をクリアするためには、AI が学習するデータ、AI の活用範囲、判断の基準にする内容、最終的な決定や判断に人間がしっかりとチェックを入れ、責任をもつことが基本となります。

トロッコ問題、ついに解決?

この難問に挑戦したある人の出した解答がこれまでにない斬新さで、動画再生回数は 760 万回を超えるほど話題に。